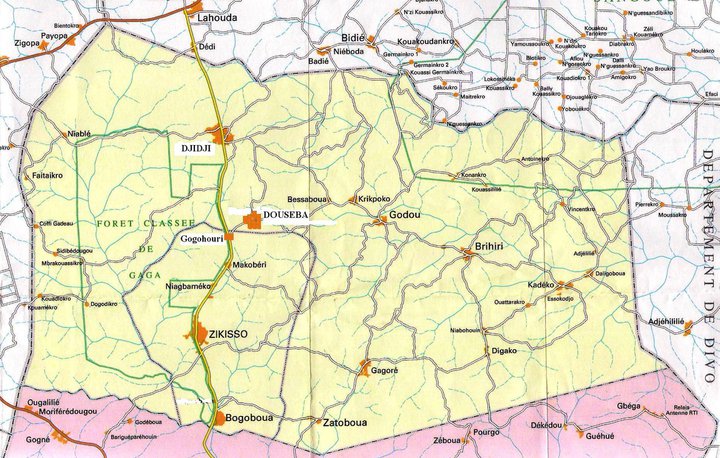

Capture d’écran d’Ava, une intelligence artificielle apparaissant sous les traits d’un robot dans le film de science fiction Ex-Machina.

Prod DB-Universal-DNA Films-Film4

L’avènement imminent d’une véritable intelligence artificielle amène certains chercheurs à développer des programmes défensifs. Comme ce “bouton rouge” de Google visant à s’assurer que l’on puisse toujours désactiver un programme apprenant.

L’Homme va-t-il réussir à créer une “intelligence artificielle (IA) forte”, c’est-à-dire consciente et au moins aussi intelligente qu’un être humain, voire que l’ensemble de l’humanité? C’est quasiment sûr. Quand? Si les spécialistes s’écharpent sur une date précise, la grande majorité s’accorde sur la fourchette 2030-2080. Le temps presse, donc, et les scientifiques réfléchissent très sérieusement aux moyens de nous protéger des dangers potentiels liés à cette révolution à venir.

Dernièrement, Stuart Armstrong, du Futur of Humanity Institute de l’université d’Oxford et Laurent Orseau, chercheur pour DeepMind, filiale de Google -qui s’est récemment illustrée grâce au programme AlphaGo-, se sont penchés sur la question, rapporte Le Monde. Leur but: créer un “gros bouton rouge” infaillible pour désactiver une IA.

“Un château de sable contre un tsunami”

“Les programmes fonctionnant par apprentissage par renforcement [avec un système de récompenses positives ou négatives, NDLR] ne peuvent pas toujours marcher parfaitement. Si un programme fonctionne en temps réel, il peut devenir nécessaire pour l’opérateur humain d’appuyer sur ‘le gros bouton rouge’ pour l’empêcher d’effectuer une séquence d’actions néfastes -pour lui-même ou pour son environnement. Mais si le logiciel s’attend à recevoir une récompense en échange de la réalisation d’une séquence, il pourrait, à la longue, apprendre à empêcher ce genre de coupure, en désactivant son ’bouton rouge'”, expliquent les scientifiques dans leur étude publiée début juin.

“Cet article explore les solutions permettant de s’assurer qu’une intelligence artificielle ne pourra pas apprendre (ou chercher) à empêcher son interruption”, précise-t-il. L’idée paraît louable, d’autant qu’il s’agit moins de répondre à une problématique actuelle que “de réfléchir à un certain futur, confessent les chercheurs au Monde. Si un jour il y a une super-intelligence, ce serait bien d’avoir certains ressorts pour agir”.

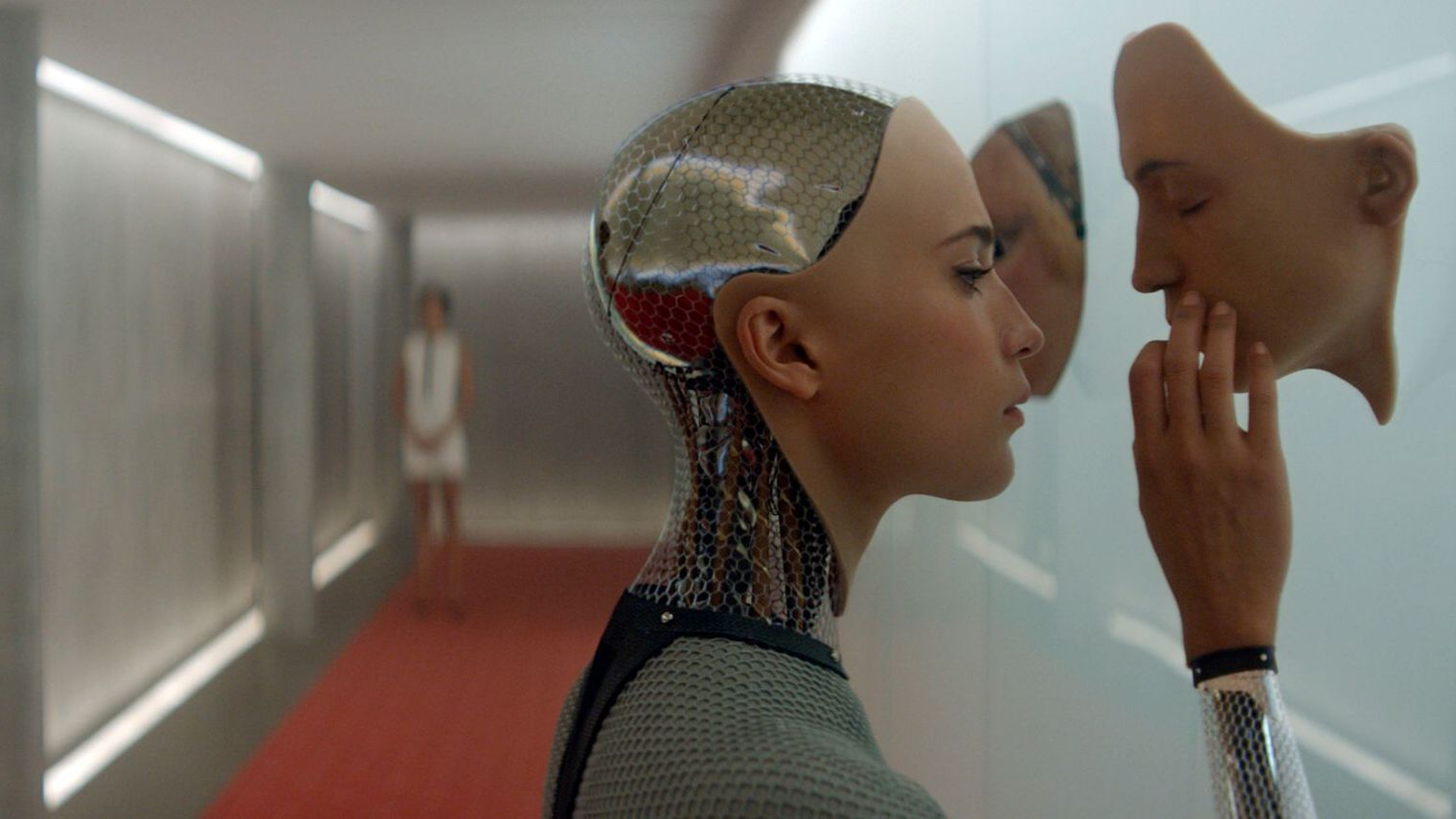

En se fondant sur la progression de la technologie, Ray Kurzweil estime que la puissance de calcul d’un cerveau humain sera égalé par une machine autour de 2025… Celle de l’humanité vers 2050.

Coutesy of Ray Kurzweil and Kurzweil Technologies, Inc.

Interrogé par L’Express, l’entrepreneur Laurent Alexandre, auteur de La mort de la mort, fondateur du site Doctissimo et spécialiste du transhumanisme estime que ce genre de réflexion “a du sens sur une IA faible”, mais en a “beaucoup moins sur une véritable IA”. En clair? Il faut distinguer les intelligences artificielles que l’on connaît, comme Siri, AlphaGo ou les Google cars pour lesquelles ce genre de bouton rouge fonctionnerait, et les potentielles IA fortes, “pour qui ce bouton rouge serait comme un château de sable contre un tsunami”.

“Une IA forte sera forcément hostile”

Aussi intelligentes que l’être humain, voire immensément plus, ces IA fortes seraient par définition conscientes, probablement connectées à Internet et dotées d’un instinct de survie. Si elles découvraient que l’être humain peut les désactiver, quelles solutions s’offriraient à elles? “La frappe préventive”, parie Laurent Alexandre, pour qui une IA forte serait “forcément hostile”. La vraie question, selon lui, est de savoir quel type d’IA l’humanité doit développer. “Une IA forte à notre service est une illusion, elle est soit forte, soit c’est un esclave, une IA toutou. Ce qui n’empêche d’ailleurs pas une IA faible, si elle est programmée pour ça, d’être nocive”, relève-t-il.

LIRE AUSSI >> “Intelligence artificielle” militaire: pourquoi les scientifiques s’inquiètent

Cette réflexion est âprement discutée au sein même de la communauté scientifique. Il y a d’un côté ceux -dont Elon Musk et Stephen Hawking-, qui redoutent le jour du Jugement dernier façon Terminator. De l’autre, on trouve notamment Facebook: son fondateur Mark Zuckerberg et son directeur du laboratoire d’intelligence artificielle Yann LeCun se veulent très rassurants. Au milieu, il y a Google qui pense qu’une potentielle IA ne pourra pas être suffisamment développée pour être dangereuse avant au moins 2050. Sans oublier Ray Kurzweil, le directeur de l’ingénierie chez Google, considéré comme le “pape” du transhumanisme, et résolument optimiste quant au développement de l’IA.

Comment éviter de gagner au “génocide bingo”?

Dans une vidéo (en anglais) publiée sur Youtube le passionné de philosophie et de technologie “Exurb1a” aborde avec humour ce débat complexe en introduisant le concept de “Bingo Génocide”. Il résume la problématique du bouton rouge et de la “frappe préventive” en expliquant “qu’avoir conscience de soi se traduit généralement, du moins dans le règne animal, par un fort instinct de survie”.

En se fondant sur la manière dont nous traitons les animaux, même les plus intelligents, il imagine ce qu’une IA pourrait nous réserver. L’humanité jouerait donc avec le feu en pariant sur le développent d’une IA “gentille”. Mais des solutions existent pour éviter le pire.

L’une d’entre-elle, selon Laurent Alexandre, serait “d’imposer aux fabricants d’équiper tous les circuits et les microprocesseurs des protections contre une IA forte”. On pourrait aussi citer les idées de nombreux scientifiques et auteurs de science-fiction. Comme les trois lois de la robotique d’Isaac Asimov et celles de Nick Bostrom dans son livre Superitntelligence: chemin, dangers et stratégie. Mais sont-elles vraiment suffisantes? Une IA consciente, comparable à l’homme, ne serait-elle pas capable de se transformer, de changer d’avis, de désobéir et d’outrepasser les règles?

LIRE AUSSI >> Robots-tueurs: ces oeuvres de science-fiction que les militaires devraient lire

La seule solution serait-elle donc d’interdire toutes les recherches sur l’intelligence artificielle? C’est à la fois quasiment impossible et probablement dommageable. D’abord parce qu’il parait difficile d’endiguer la course à l’investissement à laquelle se livrent les plus grandes entreprises technologiques –Google, Amazon, Facebook, Apple, IBM… Et même si on limitait les recherches, autorisant seulement les intelligences artificielles faibles, le risque qu’elles évoluent d’elles-mêmes persisterait.

“Est-il malin d’apprendre aux IA à nous baiser?”

Le projet de ’bouton rouge’ est en l’état probablement inefficace contre une IA avancée, mais va dans le bon sens. “Il est normal que la police de l’IA balbutie, nous n’avons pas encore suffisamment réfléchi sur le sujet. Les comités d’éthique [comme celui de Google, NDLR] sont en première ligne, mais ce n’est que le tout début. Il est urgent de réfléchir à la police de l’IA qui va être le principal métier pérenne du futur, s’avance Laurent Alexandre, car la problématique de l’IA, c’est LE sujet qui va nous occuper quelques milliards d’années… Jusqu’à la fin de l’univers, en fait”.

Arrêter les recherches sur l’intelligence artificielle, ce serait aussi prendre le risque de se passer d’une aide quasi-illimitée à la recherche, au développement, à la médecine, voire à la résolution de problèmes majeurs comme le réchauffement climatique.

Pour certains, comme Exurb1a, limiter l’intelligence artificielle consisterait à se priver de la capacité d’ “engendrer nos successeurs”. Pour appuyer son propos, il convoque le théoricien de la communication Marshall McLuhan: “L’Homme pourrait devenir l’organe sexuel du monde des machines”. En attendant, “on peut se demander s’il est malin d’apprendre la stratégie aux IA, ou à nous ‘baiser’ dans des jeux de stratégie comme le jeu de go ou Starcraft“, conclut, plus prosaïquement, Laurent Alexandre.

LAISSER UN COMMENTAIRE